Las Redes Neuronales Recurrentes (RNN, por sus siglas en inglés, Recurrent Neural Networks) son un tipo de arquitectura de redes neuronales artificiales diseñadas para procesar secuencias de datos. A diferencia de las redes neuronales convencionales, las RNN tienen conexiones retroalimentadas que les permiten mantener y utilizar información de iteraciones anteriores en la secuencia.

La principal característica de las RNN es su capacidad para modelar dependencias temporales en los datos de entrada. Esto significa que pueden capturar la estructura y el contexto de las secuencias, lo que las hace especialmente útiles en tareas relacionadas con el procesamiento del lenguaje natural, reconocimiento de voz, traducción automática, generación de texto, entre otros.

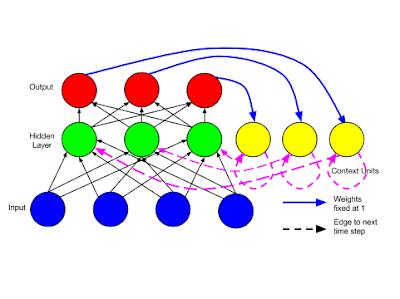

En una RNN, cada unidad de procesamiento (neurona) tiene una entrada, una salida y una conexión recurrente consigo misma. Durante el procesamiento de la secuencia, la salida de una unidad se utiliza como entrada en la siguiente iteración, lo que permite que la red mantenga una memoria interna o estado oculto que se actualiza y modifica a medida que se procesan los datos de entrada.

Existen diferentes variantes de RNN, como la RNN de Elman, la RNN de Jordan y las RNN de puertas, como la popular red neuronal LSTM (Long Short-Term Memory) y GRU (Gated Recurrent Unit), que incorporan mecanismos de puertas para controlar el flujo de información en la red y mitigar el problema del desvanecimiento de gradientes, que puede ocurrir durante el entrenamiento de redes neuronales profundas.

En resumen, las Redes Neuronales Recurrentes son una clase de arquitecturas de redes neuronales que permiten el procesamiento de secuencias de datos al mantener y utilizar información contextual de iteraciones anteriores. Su capacidad para modelar dependencias temporales las hace útiles en una amplia gama de aplicaciones de procesamiento de secuencias.

Comentarios

Publicar un comentario